PyCharm搭建Spark開發(fā)環(huán)境的實現(xiàn)步驟-創(chuàng)新互聯(lián)

1.安裝好JDK

下載并安裝好jdk-12.0.1_windows-x64_bin.exe,配置環(huán)境變量:

- 新建系統(tǒng)變量JAVA_HOME,值為Java安裝路徑

- 新建系統(tǒng)變量CLASSPATH,值為 .;%JAVA_HOME%\lib\dt.jar;%JAVA_HOME%\lib\tools.jar;(注意最前面的圓點)

- 配置系統(tǒng)變量PATH,添加 %JAVA_HOME%bin;%JAVA_HOME%jrebin

在CMD中輸入:java或者java -version,不顯示不是內(nèi)部命令等,說明安裝成功。

2.安裝Hadoop,并配置環(huán)境變量

下載hadoop:https://www.apache.org/dyn/closer.cgi/hadoop/common/hadoop-2.7.7/hadoop-2.7.7.tar.gz

- 解壓hadoop-2.7.7.tar.gz特定路徑,如:D:\adasoftware\hadoop

- 添加系統(tǒng)變量HADOOP_HOME:D:\adasoftware\hadoop

- 在系統(tǒng)變量PATH中添加:D:\adasoftware\hadoop\bin

- 安裝組件winutils:將winutils中對應(yīng)的hadoop版本中的bin替換自己hadoop安裝目錄下的bin

3.Spark環(huán)境變量配置

spark是基于hadoop之上的,運行過程中會調(diào)用相關(guān)hadoop庫,如果沒配置相關(guān)hadoop運行環(huán)境,會提示相關(guān)出錯信息,雖然也不影響運行。

- 下載對應(yīng)hadoop版本的spark:http://spark.apache.org/downloads.html

- 解壓文件到:D:\adasoftware\spark-2.4.3-bin-hadoop2.7

- 添加PATH值:D:\adasoftware\spark-2.4.3-bin-hadoop2.7\bin;

- 新建系統(tǒng)變量SPARK_HOME:D:\adasoftware\spark-2.4.3-bin-hadoop2.7;

4.下載安裝anaconda

anaconda集成了python解釋器和大多數(shù)python庫,安裝anaconda 后不用再安裝python和pandas numpy等這些組件了。下載地址。最后將python加到path環(huán)境變量中。

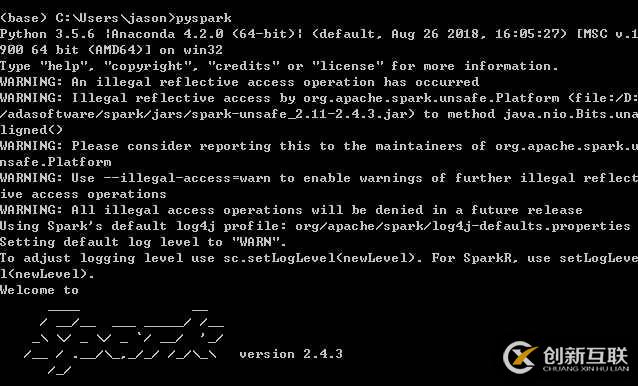

5.在CMD中運行pyspark,出現(xiàn)類似下圖說明安裝配置正常:

出現(xiàn)這種warning是因為JDK版本為12,太高了,但是不影響運行。沒有影響。

6.在pycharm中配置spark

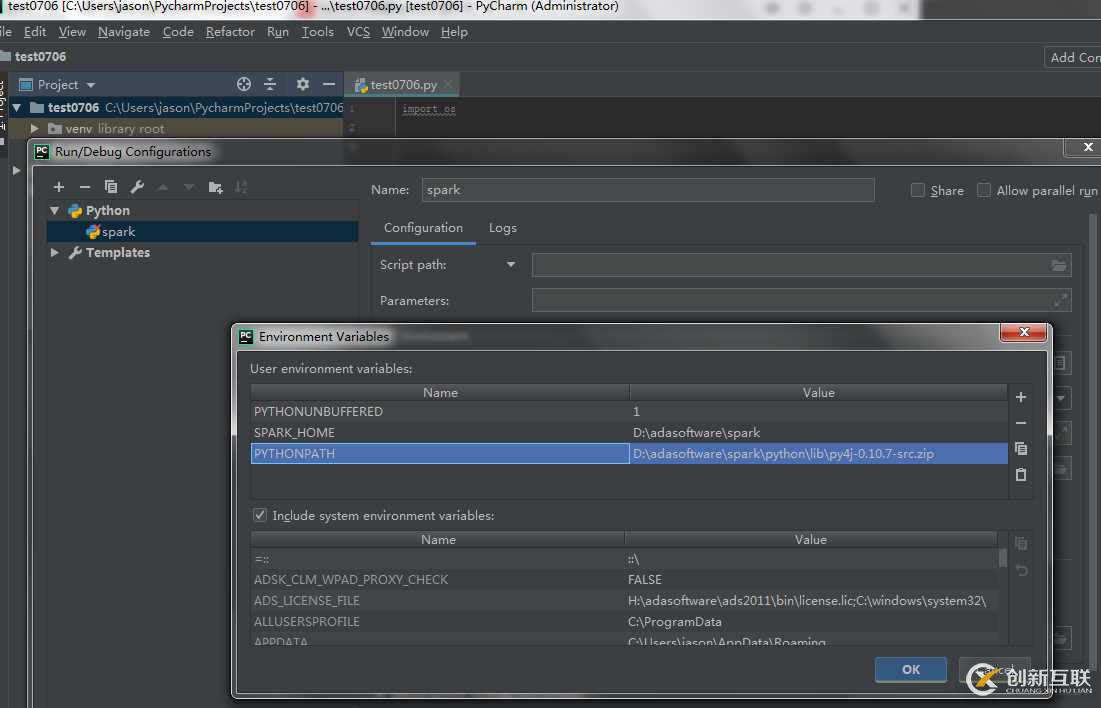

打開PyCharm,創(chuàng)建一個Project。然后選擇“Run” ->“Edit Configurations”–>點擊+創(chuàng)建新的python Configurations

選擇 “Environment variables” 增加SPARK_HOME目錄與PYTHONPATH目錄。

- SPARK_HOME:Spark安裝目錄

- PYTHONPATH:Spark安裝目錄下的Python目錄

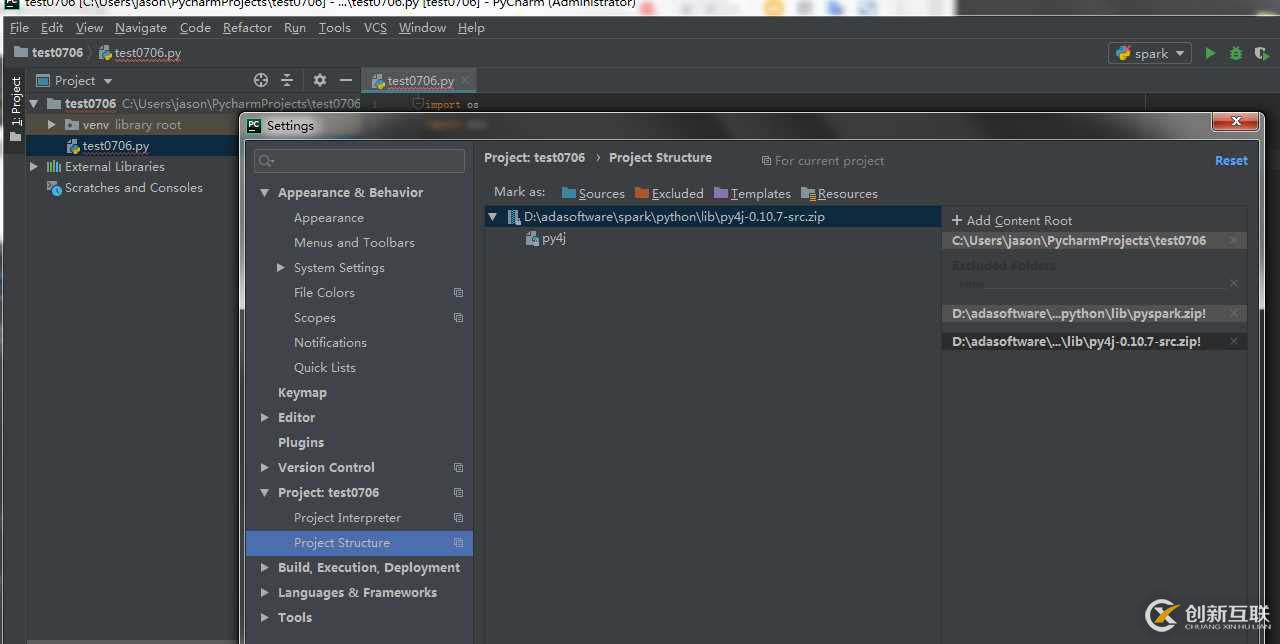

選擇 File->setting->你的project->project structure

右上角Add content root添加:py4j-some-version.zip和pyspark.zip的路徑(這兩個文件都在Spark中的python文件夾下)

保存即可

7.測試是否配置成功,程序代碼如下,創(chuàng)建一個python程序放進去就可以:

import os

import sys

# Path for spark source folder

os.environ['SPARK_HOME'] = "D:\adasoftware\spark"

# Append pyspark to Python Path

sys.path.append("D:\adasoftware\spark\python")

try:

from pyspark import SparkContext

from pyspark import SparkConf

print("Successfully imported Spark Modules")

except ImportError as e:

print("Can not import Spark Modules", e)

sys.exit(1)另外有需要云服務(wù)器可以了解下創(chuàng)新互聯(lián)scvps.cn,海內(nèi)外云服務(wù)器15元起步,三天無理由+7*72小時售后在線,公司持有idc許可證,提供“云服務(wù)器、裸金屬服務(wù)器、高防服務(wù)器、香港服務(wù)器、美國服務(wù)器、虛擬主機、免備案服務(wù)器”等云主機租用服務(wù)以及企業(yè)上云的綜合解決方案,具有“安全穩(wěn)定、簡單易用、服務(wù)可用性高、性價比高”等特點與優(yōu)勢,專為企業(yè)上云打造定制,能夠滿足用戶豐富、多元化的應(yīng)用場景需求。

分享文章:PyCharm搭建Spark開發(fā)環(huán)境的實現(xiàn)步驟-創(chuàng)新互聯(lián)

分享鏈接:http://www.chinadenli.net/article32/djohpc.html

成都網(wǎng)站建設(shè)公司_創(chuàng)新互聯(lián),為您提供App設(shè)計、自適應(yīng)網(wǎng)站、網(wǎng)站制作、云服務(wù)器、App開發(fā)、標(biāo)簽優(yōu)化

聲明:本網(wǎng)站發(fā)布的內(nèi)容(圖片、視頻和文字)以用戶投稿、用戶轉(zhuǎn)載內(nèi)容為主,如果涉及侵權(quán)請盡快告知,我們將會在第一時間刪除。文章觀點不代表本網(wǎng)站立場,如需處理請聯(lián)系客服。電話:028-86922220;郵箱:631063699@qq.com。內(nèi)容未經(jīng)允許不得轉(zhuǎn)載,或轉(zhuǎn)載時需注明來源: 創(chuàng)新互聯(lián)

猜你還喜歡下面的內(nèi)容

- 在css中改變光標(biāo)樣式的方法-創(chuàng)新互聯(lián)

- 如何理解MySQL5.7中的redolog事務(wù)日志大小調(diào)整-創(chuàng)新互聯(lián)

- 云計算的五大核心技術(shù)分別是什么-創(chuàng)新互聯(lián)

- 怎么啟用只讀OracleHome目錄-創(chuàng)新互聯(lián)

- css中border-top-style屬性如何使用-創(chuàng)新互聯(lián)

- 如何使用Android實現(xiàn)常見的驗證碼輸入框-創(chuàng)新互聯(lián)

- 如何在SSH代理中實現(xiàn)秘密握手-創(chuàng)新互聯(lián)

- 月湖小程序開發(fā)不可忽視的功能 2020-12-13

- 為什么說微信小程序開發(fā)者需要格外用心 2022-11-12

- 小程序商城怎么做直播? 2013-09-25

- 企業(yè)小程序開發(fā)能帶來哪些價值? 2020-12-27

- 企業(yè)培訓(xùn)小程序開發(fā)該怎么做? 2021-01-05

- 上海維修類小程序開發(fā)有哪些優(yōu)勢 2021-01-04

- 企業(yè)通過開發(fā)小程序可以提升發(fā)展力嗎? 2014-01-30

- 你必須了解的三大企業(yè)微信小程序開發(fā)要求 2021-02-04

- 怎樣盡可能地將成都小程序開發(fā)的成本降低? 2022-07-18

- 微信小程序開發(fā)能給商家產(chǎn)生哪些效益呢 2021-10-31

- 微信小程序開發(fā)好之后還需要做些什么? 2022-08-05

- 小程序開發(fā):百度智能小程序適合詳細介紹 2023-03-25