python爬蟲中偽裝瀏覽器的方法

小編給大家分享一下python爬蟲中偽裝瀏覽器的方法,相信大部分人都還不怎么了解,因此分享這篇文章給大家參考一下,希望大家閱讀完這篇文章后大有收獲,下面讓我們一起去了解一下吧!

成都創(chuàng)新互聯(lián)公司-云計(jì)算及IDC服務(wù)提供商,涵蓋公有云、IDC機(jī)房租用、棕樹數(shù)據(jù)中心、等保安全、私有云建設(shè)等企業(yè)級(jí)互聯(lián)網(wǎng)基礎(chǔ)服務(wù),歡迎咨詢:13518219792

實(shí)現(xiàn)偽裝瀏覽器須知:

我們?nèi)绻肴カ@取某些內(nèi)容,得先讓自己和他們處于同類,這樣才不會(huì)被攻擊,才可以跟對手網(wǎng)站和平相處,接收到他們的信息。引入ProxyHandler組件,訪問需要通過build_opener調(diào)用handler來實(shí)現(xiàn)。

實(shí)現(xiàn)代碼如下:

from urllib.request import Request, build_opener

from fake_useragent import UserAgent

from urllib.request import ProxyHandler

url = "http://httpbin.org/get"

headers={

"User-Agent": UserAgent().chrome

}

request = Request(url, headers=headers)

handler = ProxyHandler({"http" : "112.85.129.8:9999"})

opener = build_opener(handler)

response = opener.open(request)

print(response.read().decode())測試結(jié)果

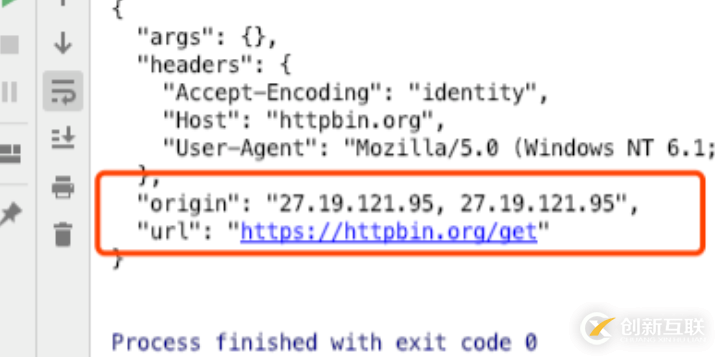

先運(yùn)行程序看看目前沒有用代理的時(shí)候IP的信息

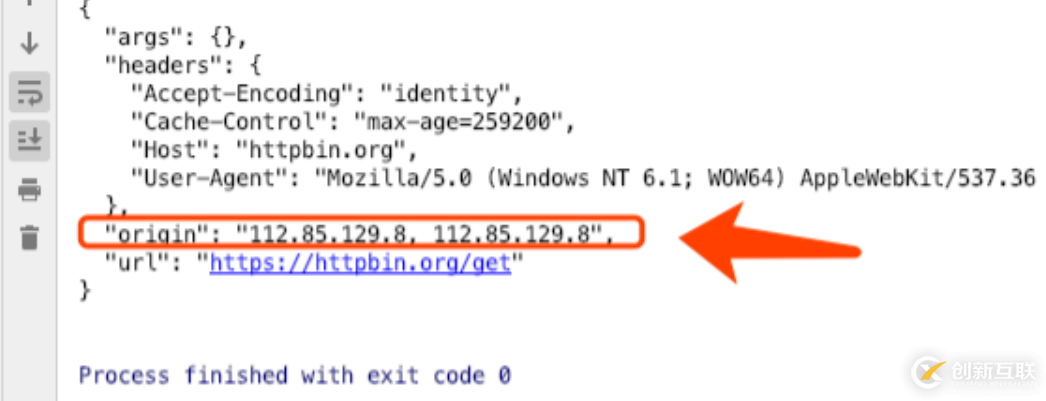

再看看利用了proxy之后產(chǎn)生的結(jié)果

以上是“python爬蟲中偽裝瀏覽器的方法”這篇文章的所有內(nèi)容,感謝各位的閱讀!相信大家都有了一定的了解,希望分享的內(nèi)容對大家有所幫助,如果還想學(xué)習(xí)更多知識(shí),歡迎關(guān)注創(chuàng)新互聯(lián)行業(yè)資訊頻道!

網(wǎng)頁題目:python爬蟲中偽裝瀏覽器的方法

分享URL:http://www.chinadenli.net/article28/ieogjp.html

成都網(wǎng)站建設(shè)公司_創(chuàng)新互聯(lián),為您提供手機(jī)網(wǎng)站建設(shè)、ChatGPT、商城網(wǎng)站、關(guān)鍵詞優(yōu)化、用戶體驗(yàn)、網(wǎng)站維護(hù)

聲明:本網(wǎng)站發(fā)布的內(nèi)容(圖片、視頻和文字)以用戶投稿、用戶轉(zhuǎn)載內(nèi)容為主,如果涉及侵權(quán)請盡快告知,我們將會(huì)在第一時(shí)間刪除。文章觀點(diǎn)不代表本網(wǎng)站立場,如需處理請聯(lián)系客服。電話:028-86922220;郵箱:631063699@qq.com。內(nèi)容未經(jīng)允許不得轉(zhuǎn)載,或轉(zhuǎn)載時(shí)需注明來源: 創(chuàng)新互聯(lián)

- 維持簡易的網(wǎng)站導(dǎo)航,增加電子商務(wù)網(wǎng)站銷售量的方法 2022-06-05

- 怎么做好網(wǎng)站導(dǎo)航SEO優(yōu)化? 2015-09-20

- 網(wǎng)站導(dǎo)航怎么做利于seo優(yōu)化? 2015-12-20

- 網(wǎng)站導(dǎo)航在網(wǎng)站制作中起什么作用? 2013-05-01

- 如何設(shè)計(jì)網(wǎng)站導(dǎo)航才能得到用戶的友好體驗(yàn) 2022-08-08

- 制作網(wǎng)站導(dǎo)航用戶體驗(yàn)度最重要 2016-11-03

- 網(wǎng)站導(dǎo)航設(shè)計(jì)的若干問題 2016-11-03

- 網(wǎng)站導(dǎo)航欄設(shè)計(jì)需要注意哪幾個(gè)方面? 2016-10-06

- 網(wǎng)站導(dǎo)航如何設(shè)計(jì)可以提高用戶體驗(yàn) 2022-11-24

- 網(wǎng)絡(luò)營銷,網(wǎng)站導(dǎo)航站推廣中的外部鏈接建設(shè)與靜態(tài)變化 2022-12-06

- 分享一些腦洞大開的網(wǎng)站導(dǎo)航設(shè)計(jì) 2015-10-18

- 企業(yè)網(wǎng)站制作中網(wǎng)站導(dǎo)航設(shè)置的4個(gè)重要因素 2021-10-03