backpropagation-創(chuàng)新互聯

http://deeplearning.stanford.edu/wiki/index.php/%E5%8F%8D%E5%90%91%E4%BC%A0%E5%AF%BC%E7%AE%97%E6%B3%95

成都創(chuàng)新互聯公司是一家專業(yè)提供米脂企業(yè)網站建設,專注與成都網站建設、成都網站制作、H5場景定制、小程序制作等業(yè)務。10年已為米脂眾多企業(yè)、政府機構等服務。創(chuàng)新互聯專業(yè)網站制作公司優(yōu)惠進行中。 反向傳播算法的思路如下:給定一個樣例  ,我們首先進行“前向傳導”運算,計算出網絡中所有的激活值,包括

,我們首先進行“前向傳導”運算,計算出網絡中所有的激活值,包括  的輸出值。之后,針對第

的輸出值。之后,針對第  層的每一個節(jié)點

層的每一個節(jié)點  ,我們計算出其“殘差”

,我們計算出其“殘差”  ,該殘差表明了該節(jié)點對最終輸出值的殘差產生了多少影響。對于最終的輸出節(jié)點,我們可以直接算出網絡產生的激活值與實際值之間的差距,我們將這個差距定義為

,該殘差表明了該節(jié)點對最終輸出值的殘差產生了多少影響。對于最終的輸出節(jié)點,我們可以直接算出網絡產生的激活值與實際值之間的差距,我們將這個差距定義為  (第

(第  層表示輸出層)。對于隱藏單元我們如何處理呢?我們將基于節(jié)點(譯者注:第

層表示輸出層)。對于隱藏單元我們如何處理呢?我們將基于節(jié)點(譯者注:第  層節(jié)點)殘差的加權平均值計算

層節(jié)點)殘差的加權平均值計算  ,這些節(jié)點以

,這些節(jié)點以  作為輸入。

作為輸入。

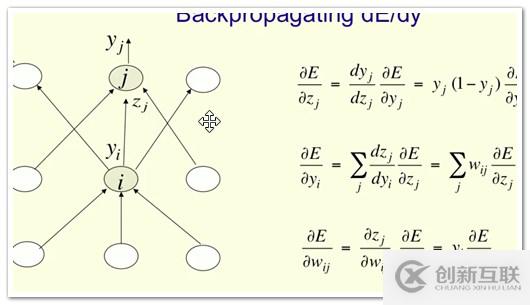

$ delta 3=frac{d Error}{d x_3}=frac{d 1/2*(t-y_3)^2}{d x} =-(t-y_3)*y_{3}^{'} $

$ delta 2=frac{d Error}{d x_2}=frac{d E}{d x_3} frac{d x_3}{d y_2} frac{d y_2}{d x_2}= delta 3*w2*y_{2}^{'} $

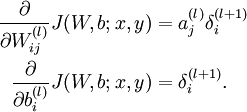

計算我們需要的偏導數,計算方法如下:

($a^(l)_j$是activation, j是前一層,i是后一層)

是sum上面一層,而forward是sum下面一層。

若不是sigmoid,則$Delta wi=exi$

還有一個問題,當f(x)接近1或接近0時,gradient非常小,幾乎為0,這時沒法更新weight,錯誤無法修正

tj只有當是結果是才為1,其余時候為0.

網站題目:backpropagation-創(chuàng)新互聯

轉載來源:http://www.chinadenli.net/article24/cceije.html

成都網站建設公司_創(chuàng)新互聯,為您提供商城網站、建站公司、電子商務、企業(yè)建站、網站內鏈、網頁設計公司

聲明:本網站發(fā)布的內容(圖片、視頻和文字)以用戶投稿、用戶轉載內容為主,如果涉及侵權請盡快告知,我們將會在第一時間刪除。文章觀點不代表本網站立場,如需處理請聯系客服。電話:028-86922220;郵箱:631063699@qq.com。內容未經允許不得轉載,或轉載時需注明來源: 創(chuàng)新互聯

- 服務器托管一定要避免的9種機房現狀 2021-03-12

- 服務器托管如何選擇好的機房? 2022-10-07

- 云服務器租用與服務器托管相比有什么優(yōu)勢 2021-02-21

- 什么是高防服務器托管? 2022-10-03

- 企業(yè)要選服務器托管的原因是什么 2022-10-03

- 什么是服務器?服務器托管與租用有什么不同? 2022-10-03

- 艾克賽樂服務器托管怎么樣? 2021-03-10

- 服務器托管與虛擬主機托管有什么區(qū)別 2022-06-20

- 關于網站服務器托管需要注意問題 2016-11-07

- 服務器托管機房選擇需要注意的幾個問題 2022-10-09

- 什么是服務器托管?服務器托管有什么好處? 2023-01-07

- 企業(yè)服務器托管有什么技巧?企業(yè)服務器托管該注意哪些問題? 2022-10-02