如何進行Spark中SparkStreaming的分析

今天就跟大家聊聊有關如何進行Spark中Spark Streaming的分析,可能很多人都不太了解,為了讓大家更加了解,小編給大家總結了以下內容,希望大家根據(jù)這篇文章可以有所收獲。

創(chuàng)新互聯(lián)是一家專注網(wǎng)站建設、網(wǎng)絡營銷策劃、微信小程序開發(fā)、電子商務建設、網(wǎng)絡推廣、移動互聯(lián)開發(fā)、研究、服務為一體的技術型公司。公司成立十年以來,已經為成百上千成都不銹鋼雕塑各業(yè)的企業(yè)公司提供互聯(lián)網(wǎng)服務。現(xiàn)在,服務的成百上千客戶與我們一路同行,見證我們的成長;未來,我們一起分享成功的喜悅。

概覽

Spark Streaming是Spark API的一個可橫向擴容,高吞吐量,容錯的實時數(shù)據(jù)流處理引擎,Spark能夠從Kafka、Flume、Kinesis或者TCP等等輸入獲取數(shù)據(jù),然后能夠使用復雜的計算表達式如map,reduce,join和window對數(shù)據(jù)進行計算。計算完后的數(shù)據(jù)能夠被推送到文件系統(tǒng),數(shù)據(jù)庫,和實時的儀表盤。另外,你也可以使用Spark ML和圖計算處理實時數(shù)據(jù)流。

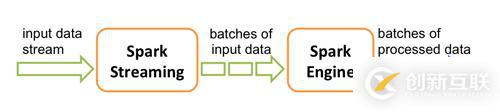

Spark Streaming接受到了實時數(shù)據(jù)后,把它們分批進行切割,然后再交給Spark進行數(shù)據(jù)的批量處理。

Spark Streaming對離散化的數(shù)據(jù)流提供了高級別的抽象DStream,所有進入的數(shù)據(jù)流都會被處理為DStreams,在內部,DStream是一個順序排列的RDD。

快速起步

第一個實例是如何從TCP輸入中計算單詞出現(xiàn)的次數(shù)

首先,我們創(chuàng)建一個JavaStreamingContext對象,它是所有Streaming函數(shù)的主入口,再創(chuàng)建一個帶有2個線程的StreamingContext對象,每1秒進行一次批處理。

import org.apache.spark.*; import org.apache.spark.api.java.function.*; import org.apache.spark.streaming.*; import org.apache.spark.streaming.api.java.*; import scala.Tuple2; SparkConf conf = new SparkConf().setMaster("local[2]").setAppName("NetworkWordCount"); JavaStreamingContext jssc = new JavaStreamingContext(conf, Durations.seconds(1));創(chuàng)建一個偵聽本地9999的TCP數(shù)據(jù)源

JavaReceiverInputDStream<String> lines = jssc.socketTextStream("localhost", 9999);我們把接受到的數(shù)據(jù)按照空格進行切割

JavaDStream<String> words = lines.flatMap(x -> Arrays.asList(x.split(" ")).iterator());對單詞進行統(tǒng)計

JavaPairDStream<String, Integer> pairs = words.mapToPair(s -> new Tuple2<>(s, 1)); JavaPairDStream<String, Integer> wordCounts = pairs.reduceByKey((i1, i2) -> i1 + i2); wordCounts.print();

把字符串拍扁->映射->進行去重統(tǒng)計,***調用print函數(shù)把數(shù)據(jù)打印到控制臺中

jssc.start(); // Start the computation jssc.awaitTermination(); // Wait for the computation to terminate

最后,啟動整個計算過程

為了完成這次實驗,還需要使用nc作為Server進行配合

nc -lk 9999

Spark提供了示例,可以使用 ./bin/run-example streaming.JavaNetworkWordCount localhost 9999 來體驗WordCount

看完上述內容,你們對如何進行Spark中Spark Streaming的分析有進一步的了解嗎?如果還想了解更多知識或者相關內容,請關注創(chuàng)新互聯(lián)行業(yè)資訊頻道,感謝大家的支持。

文章名稱:如何進行Spark中SparkStreaming的分析

文章起源:http://www.chinadenli.net/article20/isjojo.html

成都網(wǎng)站建設公司_創(chuàng)新互聯(lián),為您提供面包屑導航、手機網(wǎng)站建設、定制網(wǎng)站、搜索引擎優(yōu)化、品牌網(wǎng)站制作、軟件開發(fā)

聲明:本網(wǎng)站發(fā)布的內容(圖片、視頻和文字)以用戶投稿、用戶轉載內容為主,如果涉及侵權請盡快告知,我們將會在第一時間刪除。文章觀點不代表本網(wǎng)站立場,如需處理請聯(lián)系客服。電話:028-86922220;郵箱:631063699@qq.com。內容未經允許不得轉載,或轉載時需注明來源: 創(chuàng)新互聯(lián)

- APP開發(fā)制作常見的六種信息展示形式 2020-11-20

- IOS系統(tǒng)APP開發(fā)為什么受追捧 2021-05-20

- 創(chuàng)新互聯(lián):APP開發(fā)公司如何選擇? 2022-12-03

- 上海購物APP為什么要做直播APP開發(fā)? 2020-12-29

- 石家莊app開發(fā)運用對于品牌的好處 2023-02-09

- 天津代駕APP開發(fā)市場需求有那些? 2023-03-22

- 長泰共享經濟APP開發(fā)哪些功能用戶比較喜歡 2020-12-12

- 重慶健身APP開發(fā)如何滿足用戶需求 2021-01-02

- 烘焙APP開發(fā)具備哪些發(fā)展優(yōu)勢? 2022-06-27

- 成都APP開發(fā),網(wǎng)絡友好度值得重視 2022-07-28

- 【網(wǎng)站建設】APP開發(fā)能為企業(yè)帶來什么價值 2016-11-14

- app開發(fā)定制:如何開發(fā)定制高質量的APP軟件 2022-07-14