機器學習中的交叉熵-創(chuàng)新互聯(lián)

- 一、背景

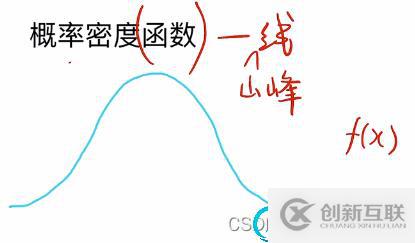

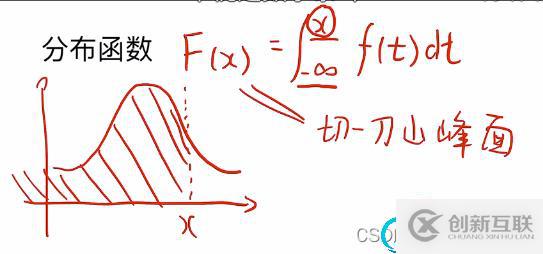

- 二、概率論基礎(chǔ)知識

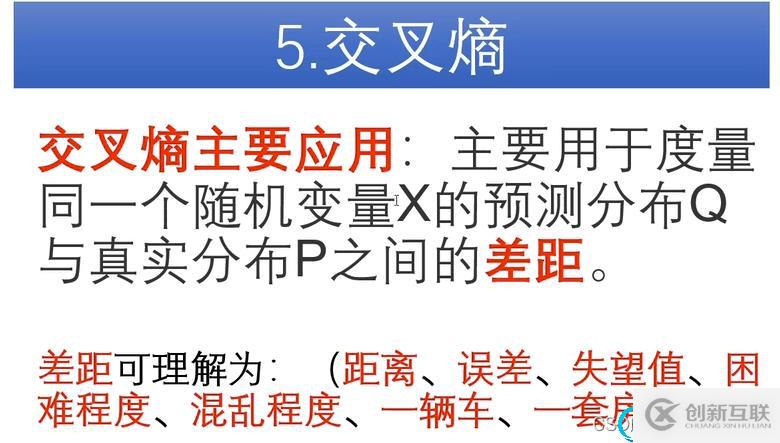

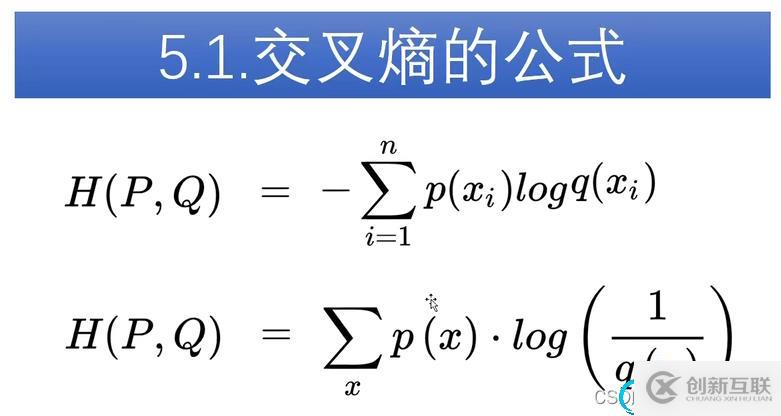

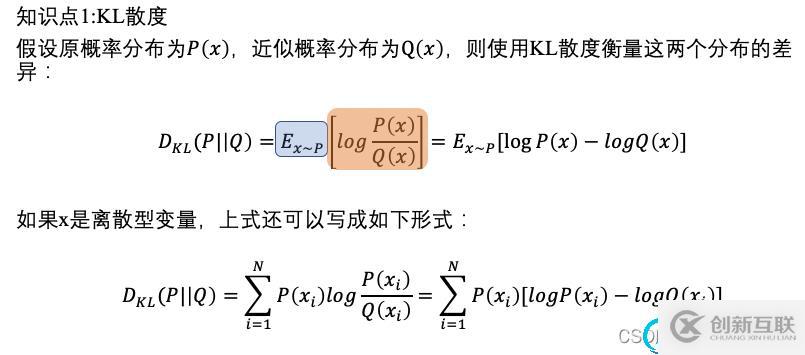

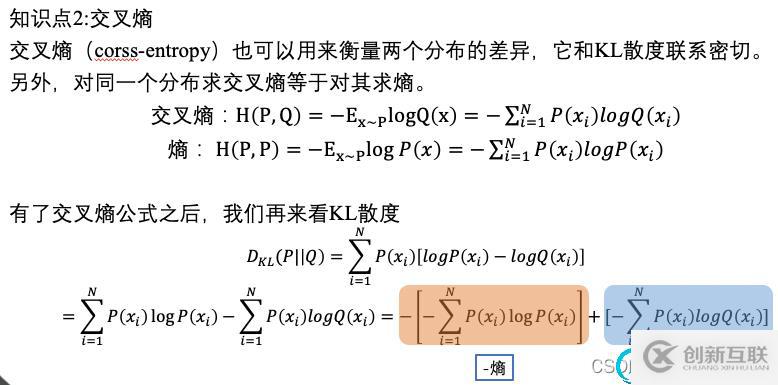

- 三、熵≈信息熵(應用領(lǐng)域不同)、相對熵=KL散度、交叉熵、softmax、sigmoid、交叉熵損失

- 四、圖像分割如何理解CrossEntropyLoss()

- 參考資料

學習機器學習過程中,總是會遇到交叉熵這個名詞。通過交叉熵損失作為損失函數(shù)來優(yōu)化模型也是學習過程中必然會遇到的場景。但是,每次當和同門或者其它人遇到或者討論什么是交叉熵的時候,總是無法從0到1講出來,往往就是說這句話:“衡量預測結(jié)果和標簽之間的分布差異,從而優(yōu)化模型,使得我們的模型預測的結(jié)果能夠與真實結(jié)果同分布。”

本文出于此目的,想要把交叉熵從原理到機器學習中的應用捋一遍,方便以后回顧以及和網(wǎng)上的你們進行不斷的探討學習。

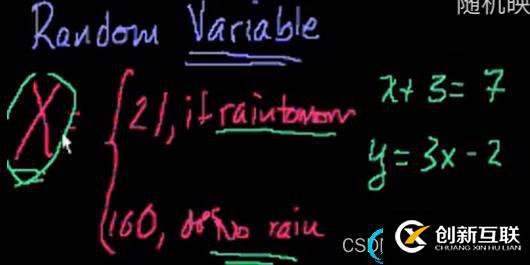

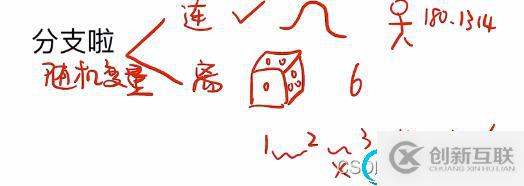

- 隨機變量

隨機變量,隨機變量可以取很多值,但和我們之前了解到的變量不同,隨機變量無法求解。隨機變量通常用大寫字母表示,例如X,Y。這樣的目的可能就是為了和傳統(tǒng)的變量區(qū)分開。但是我們將其稱之為變量又會對人誤導,它其實是一種函數(shù),將隨機過程映射到實際數(shù)字中。比如說我想量化一個隨機過程是,明天是否會下雨。你可以等到明天來看,也可以來量化。你可以定義一個隨機變量,如果明天下雨就是1,如果不下就是0,不一定賦值0或者1,只是0或者1更好用而已。我們可以賦值21和100,這取決于你如何定義。隨機變量和一般變量的差別要牢記,它并非傳統(tǒng)觀念意義上的變量,更像是從隨機過程(下雨或者不下雨這個隨機過程)映射到數(shù)值的函數(shù),這個數(shù)值是隨機的,獲取我們知道概率的話,就可以將值映射為概率。

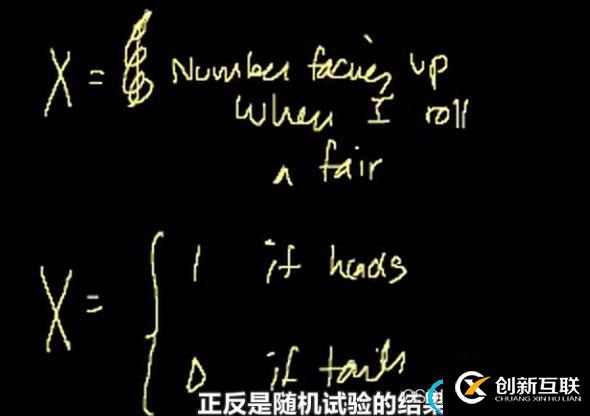

隨機拋硬幣是一個隨機過程,每拋一次都是一次試驗。隨機變量可以用來量化這個隨機試驗。 簡單來說,隨機變量就是函數(shù)映射,這里講到的隨機變量的概念將會和概率結(jié)合起來,形成非常有用的知識架構(gòu)。對隨機變量的量化的意義就在這里。

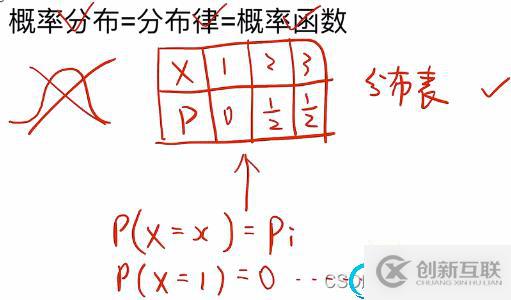

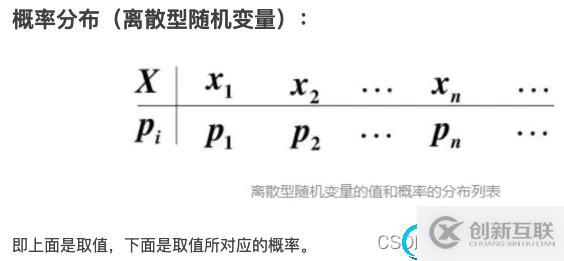

離散型隨機變量X的概率分布=分布律=概率函數(shù);

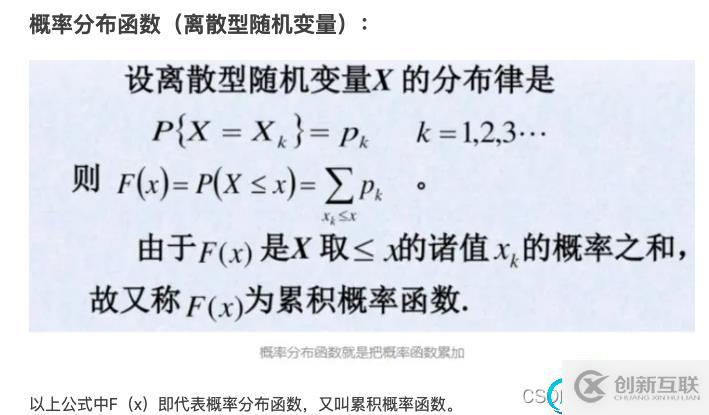

而離散型隨機變量的概率分布函數(shù)F(x)就是把概率函數(shù)累加,因此又稱之為累積概率函數(shù);

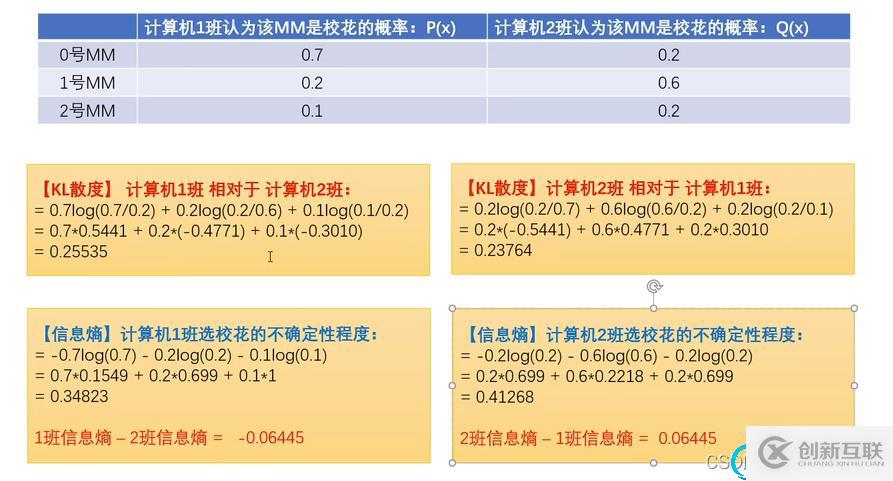

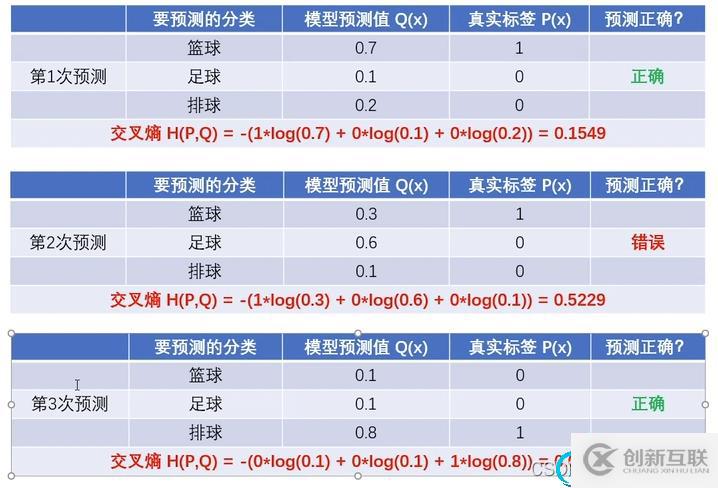

舉例加深對交叉熵的理解:

從例子中可以看出,給出的正確預測概率值越高的那個預測,標簽對預測結(jié)果的交叉熵其實是最小的。

補充:0*任何數(shù)都是零;真是標簽使用one hot編碼的意義就是,表示的是隨機變量(樣本)的概率分布;交叉熵對于連續(xù)變化的信號(連續(xù)型隨機變量的信號的效果是很差的,連續(xù)的一般用均方差),離散型一般用交叉熵,效果也較好。

q

(

c

i

)

q(c_i)

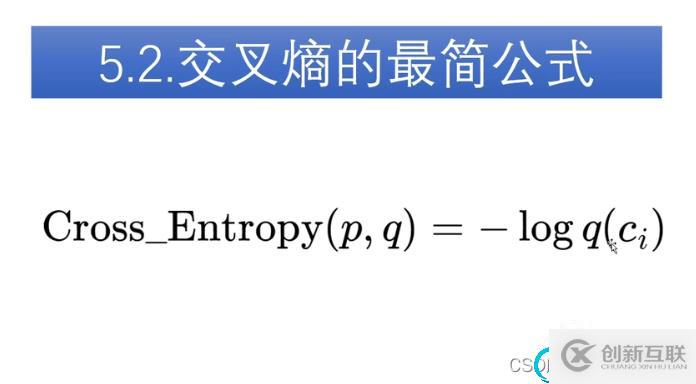

q(ci?)代表預測為真實標簽的概率。

補充:(源自深度之眼:Line講解)

其中l(wèi)g和log在計算機中默認是以10為底。

其實就是像素級別的分類問題,對每個像素分類結(jié)果求交叉熵之后,求和取平均。

參考內(nèi)容:pytorch語義分割中CrossEntropyLoss()損失函數(shù)的理解與分析

bilibili一個視頻徹底搞懂交叉熵、信息熵、相對熵、KL散度、交叉熵損失、交叉熵損失函數(shù)、softmax

【公開課-85集全】可汗學院:統(tǒng)計學(強烈推薦)

你是否還在尋找穩(wěn)定的海外服務器提供商?創(chuàng)新互聯(lián)www.cdcxhl.cn海外機房具備T級流量清洗系統(tǒng)配攻擊溯源,準確流量調(diào)度確保服務器高可用性,企業(yè)級服務器適合批量采購,新人活動首月15元起,快前往官網(wǎng)查看詳情吧

新聞名稱:機器學習中的交叉熵-創(chuàng)新互聯(lián)

分享地址:http://www.chinadenli.net/article16/dgcpdg.html

成都網(wǎng)站建設公司_創(chuàng)新互聯(lián),為您提供網(wǎng)站內(nèi)鏈、關(guān)鍵詞優(yōu)化、做網(wǎng)站、搜索引擎優(yōu)化、定制網(wǎng)站、標簽優(yōu)化

聲明:本網(wǎng)站發(fā)布的內(nèi)容(圖片、視頻和文字)以用戶投稿、用戶轉(zhuǎn)載內(nèi)容為主,如果涉及侵權(quán)請盡快告知,我們將會在第一時間刪除。文章觀點不代表本網(wǎng)站立場,如需處理請聯(lián)系客服。電話:028-86922220;郵箱:631063699@qq.com。內(nèi)容未經(jīng)允許不得轉(zhuǎn)載,或轉(zhuǎn)載時需注明來源: 創(chuàng)新互聯(lián)

猜你還喜歡下面的內(nèi)容

- Javascript模塊化機制原理是什么-創(chuàng)新互聯(lián)

- 評分條RatingBar-創(chuàng)新互聯(lián)

- 網(wǎng)頁設計中要關(guān)注的搜索優(yōu)化知識有哪些-創(chuàng)新互聯(lián)

- springboot2.0以上調(diào)度器配置線程池的實現(xiàn)-創(chuàng)新互聯(lián)

- Winform控件SaveFileDialog保存文件的案例-創(chuàng)新互聯(lián)

- Xdebug性能分析工具如何在PHP中使用-創(chuàng)新互聯(lián)

- 使用JTable創(chuàng)建Java表的方法-創(chuàng)新互聯(lián)

- 外貿(mào)營銷型網(wǎng)站建設攻略 2013-10-06

- 深圳網(wǎng)站營銷型網(wǎng)站建設的幾點要素 2022-04-30

- 營銷型網(wǎng)站建設如何提升網(wǎng)絡運營轉(zhuǎn)化四大秘訣 2022-12-03

- 東明營銷型網(wǎng)站建設有哪些優(yōu)勢 2020-12-19

- 成都營銷型網(wǎng)站建設的小知識 2017-01-17

- 營銷型網(wǎng)站建設和傳統(tǒng)網(wǎng)站設計制作有何區(qū)別 2022-03-30

- 有的營銷型網(wǎng)站建設很便宜是怎么回事 2016-10-07

- 成都營銷型網(wǎng)站建設的三個核心點 2022-06-21

- 上海營銷型網(wǎng)站建設應該怎么做才能更好? 2020-12-13

- 營銷型網(wǎng)站建設都有什么特點? 2020-10-30

- 阿拉善營銷型網(wǎng)站建設實際效果受哪些因素影響? 2023-03-03

- 電商平臺營銷型網(wǎng)站建設如何變革? 2022-12-10